Die Informationspraxis war eine Zeitschrift für Bibliotheken, Informationseinrichtungen und vergleichbare Einrichtungen, welche von 2015 bis 2022 erschien. Sie war auf den deutschsprachigen Raum ausgerichtet (explizit stand hinter der Zeitschrift ein schweizerischer Verein, wenn auch der Grossteil der Redaktion in Deutschland arbeitete) und erschien – wie alle vergleichbaren Zeitschriften, die in dieser Zeit gegründet wurden – als reine Open Access Zeitschrift. Gleichzeitig versuchte sie, Abläufe zu verändern – die Redaktion wollte nicht einfach eine «weitere Zeitschrift» machen, sondern Neues ausprobieren. Das zeigte sich vor allem am Open Peer Review, bei dem Artikel in einer ersten Version im Blog des Zeitschrift publiziert wurden, dort offen kommentiert werden konnten, diese Kommentare gesammelt und an die Autor*innen zurückgemeldet wurden, welche darauf (und auf Kommentare der Redaktion) reagierten, bevor die endgültige Fassung des jeweiligen Artikels erschien. (In meiner Erfahrung als Autor gab es allerdings immer wenige Kommentare, ausserdem lernte die Redaktion, dass es manchmal wichtig ist, sich «dazwischenzuschalten», da einige Leute halt nicht wissen, wie man potentialorientiert kommentiert.) Als Redaktionssystem wurde OJS genutzt – das wird kurz weiter unten relevant werden.

Die Redaktion beendete die Zeitschrift mit einem ganz kurzen Hinweis auf der Homepage. Es gab keine abschliessenden Text. Soweit ich das sehe, hat auch niemand sonst einen Nachruf oder Ähnliches veröffentlicht, abgesehen von einigen Social Media Kommentaren, die Bedauern über das Ende ausdrückten. Auch dieser Text hier wird nicht darüber reflektieren, warum die Zeitschrift eingestellt wurde und was dies (vielleicht) über das Bibliothekswesen im DACH-Raum sagt. Ich denke, dass müsste jemand machen, die*der die ganze Zeit in der Redaktion gewesen ist. (Was möglich wäre: Die «Laufzeit» von acht Jahren, scheint mir, wäre eine gute Voraussetzung für so eine Reflexion. Lang genug, als das es Veränderungen gab, aber kurz genug, um diese Zeit vollständig zu Überblicken.)

Aber die Informationspraxis stellt auch eine Chance dar: Es gibt mit ihr eine «abgeschlossene» Sammlung an Texten aus dem Bibliothekswesen, relativ aktuell, ausgewählt und bearbeitet von einer fachspezifischen Redaktion. Es sind ausreichend viele Texte, um aus ihnen einige Statistiken abzuleiten und etwas Textmining zu betreiben. (Es sind nicht wirklich genug für komplexere Textmining-Modelle. Das wird weiter unten noch thematisiert werden.) Und das soll hier, anstatt eines Nachrufs, geliefert werden: Die Informationspraxis wird als Datensatz behandelt und einige statische Daten über sie dargestellt. (Die Nutzungs-/Abrufstatistiken sind nicht darunter – die liegen wohl im OJS selber und müssten von der ehemaligen Redaktion veröffentlicht werden. In der «Geschichte» der Zeitschrift ist das auch passiert (https://informationspraxis.de/2019/01/07/der-informationspraxis-lesebericht-2018/), aber nicht bei ihrem Ende.)

Aufgebaut ist der Beitrag wie folgt: im nächsten Abschnitt (1) wird kurz die «technische» Seite beschrieben – also, wie die Daten für diesen Beitrag hier gesammelt, aufbereitet und verarbeitet wurden. Wer das nicht unbedingt wissen will, kann den getrost überspringen. Anschliessend (2) werden einige Statistiken über die Zeitschrift selber dargestellt. Hier geht es dann vor allem um die Anzahl der Ausgaben oder die Zahl der Autor*innen. Dann geht es ans Textmining, also an die Frage, was sich auf statistische Weise aus den eigentlichen Beiträge herauslesen lässt. Unterteilt ist dies nochmal in einfache Statistiken (3) wie die Auszählung der Worte, die verwendet wurden und komplexere Statistiken (4), die etwas tiefer in die Materien gehen. Wie wohl zu erwarten wird dann in einem abschliessenden Abschnitt (5) versucht, einige Schlüsse zu ziehen und mögliche weitere Fragen aufzuzeigen. In einem kurzen Nachwort (6) gehe ich dann doch noch mal auf meine abschliessende Bewertung der Informationspraxis ein – wie im Abschnitt 2 sichtbar wird, war ich erstaunlicherweise einer der «Top-Autor*innen», was mich doch zu einem Kommentar drängt.

Alle Daten hier im Beitrag können heruntergeladen werden und stehen unter einer CC BY NC 4.0-Lizenz.

1. R, Datascrapping und spezialisierte Libraries – zur «technischen» Seite

Alle Daten und Statistiken, die weiter unten dargestellt werden, sind mit der Statistiksprache R produziert worden. (Verwendet wurde Version 4.2.2 in R-Studio Version 2023.09.01.) Die verwendeten Libraries waren auf die jeweils neueste Version geupdatet. Das ganze Projekt war auch ein Experiment dazu, was heute mit diesen recht einfachen Mitteln möglich ist. Das ganze nahm vielleicht drei Arbeitstage (verteilt über eine Woche in den Stunden «nebenher») in Anspruch. Deshalb war / ist auch vieles handgestrickt und nicht perfekt, sondern experimentell. Kolleg*innen in den Digital Humanities, die sich ständig mit Textmining und Ähnlichem beschäftigen, werden selbstverständlich viel schneller zu den gleichen Ergebnissen gelangen und dann auch zu viel differenzierten, besseren. Es sollte als Experiment verstanden werden, aber eines, dass sich auch von anderen Personen recht einfach reproduzieren lässt. (Ein Experiment, dass auch davon motiviert ist, dass ein Kollege aus der ehemaligen Redaktion der Informationspraxis oft davon gesprochen hat, wenn wir das paraphrasieren, «einmal was mit Data- und Textmining machen zu wollen». Da erschien es nur passend, dass an der Zeitschrift selber durchzuführen, nachdem sie eine «abgeschlossene Sammlung» wurde.)

Ermöglicht wurde dies durch zwei Fakten:

- Die Informationspraxis erschien, wie gesagt, kontinuierlich im Open Access (mit CC BY 4.0) und auf einem OJS. Das heisst, erstens sind die Daten strukturiert (weil sie aus dem OJS strukturiert ausgegeben werden, zumindest wenn dort nicht viel verändert wird – was die Informationspraxis nicht tat) und zweitens sind die Rechte geklärt: Die Texte dürfen für ein Text,ining verwendet werden.

- Datamining, auch auf der Basis von Artikeln und Zeitschriften, die auf einem OJS veröffentlicht wurden, stellen in gewisser Weise Standardaufgaben dar. Es gibt für sie schon etablierte Libraries (nicht nur, aber auch für R), die dafür einfach verwendet werden konnten. In unserem Fall waren dies ojsr (https://www.rdocumentation.org/packages/ojsr/versions/0.1.2) für das Einlesen der Metadaten von der Homepage, rvest (https://www.rdocumentation.org/packages/rvest/versions/1.0.3) für das Textscrapping der Volltexte und quanteda (https://quanteda.io), inklusive der «Unterpackages» für textstats, textplots und textmodels, für das Textmining.

Vorgegangen wurde nun, in gewisser Weise auch schon standardisiert, wie folgt:

- Zuerst wurden mithilfe von ojsr die gesamten Metadaten der Informationspraxis eingelesen. Das ist genau die Aufgabe, für welche dieses Paket geschrieben wurde. (Es funktioniert auch mit allen anderen Zeitschriften, die auf OJS gehostet werden, solange sie die grundlegende Metadatenstruktur beibehalten.) Insoweit war es direkt aus dem in der Beschreibung des Pakets gegebenen Beispiel umsetzbar.

- Ebenso direkt und einfach umsetzbar war das Scrapping der eigentliche Volltexte. Hierzu wurden die URLs, die in den Daten aus dem ersten Schritt enthalten waren, genutzt, um dann mit dem Paket rvest die gesamten HTML-Inhalte aller Artikel der Informationspraxis herunterzuladen und dann so umzuformatieren, dass sie weiterverarbeitet werden konnten.

- Anschliessend wurden die Daten zusammengeführt und, beispielsweise, die jedem Artikel beigegebene Unterzeile «Informationspraxis mitgestalten?Hier steht, wie’s geht!» gelöscht. Am Ende stand ein Datensatz, in welchem für jeden Artikel in einer Zeile Metadaten, eine eindeutige Kennung und – jeweils in einer Zelle – der gesamte Text stand. [Die eindeutige Kennung besteht aus einer durchlaufen Zahl und dem Beginn der bibliographischen Angaben. Die gesamten bibliographischen Angaben waren in den Graphiken nicht zu lesen. Am Ende dieses Artikels findet sich aber eine Tabelle, welche diese Kennung und die bibliographischen Angaben darstellt, sodass auch auf einzelne Artikel zurückgeschlossen werden kann.] Dieses Format – genauer: eine Tabelle mit Volltext und Identifier – war notwendig für die Weiterverarbeitung mit dem Paket quanteda.

- In einem ersten Schritt der Analyse wurde mit den reinen Metadaten gearbeitet. Es wurde in jeweils kleineren Datensätzen zusammengefasst, welche Autor*innen die Artikel der Informationspraxis hatten, wie viele Ausgaben es gab etc. Auch hiermit liess sich schon ein interessanter Überblick erarbeiten, welcher weiter unten in Abschnitt 2 dargestellt ist.

- Anschliessend wurde das Textmining durchgeführt. Für dieses gibt es eine ganze Anzahl von Paket in R. Gewählt wurde, weil ich schon von einigen früheren Versuchen ein wenig mit ihm vertraut war und weil es in der Literatur zum Textmining immer wieder erwähnt wird, das Paket quanteda. Dieses bietet Funktionen, um sehr einfach Textmining durchzuführen – doch wie immer bei solchen Paketen übernimmt es die Arbeit, nicht aber die konkrete Interpretation der Daten. Zuerst wurden die Daten in einen Corpus umgewandelt, mit dem dann weitergearbeitet werden konnte. Das ist der Teil, für den die Datenstruktur Identifier und Volltext notwendig war. (Diese werden in eine Struktur umgearbeitet, in denen der Text in einen Container liegt, der Identifier auf ihn verweist und dann die anderen Metadaten, die vielleicht auch in den Tabelle liegen – beispielsweise in unserem Fall die Erscheinungsjahre der Artikel – als Kategorien angelegt sind.) Und dann wurden die verschiedenen Möglichkeiten des Textminings, die quanteda bietet «durchgespielt». Nicht alle ergaben sinnvoll interpretierbare Daten und selbstverständlich kann man immer weiter hinter die Möglichkeiten, die das Paket bietet, steigen. Was hier in Abschnitt 3 präsentiert wird, sind die Ergebnisse, die im Laufe dieses Experiments erstellt wurde und präsentabel erschienen. (Aber der Quellcode ist auch am Ende des Beitrags als Datei eingefügt, so dass alle ihn nachvollziehen, selber «laufen lassen» und gerne auch erweitern / verändern dürfen.)

- Für die Darstellung der Daten und Plots hier wird in vielen Fällen das WordPress-Plugin wpDataTables (https://wpdatatables.com) verwendet. Die anderen Plots wurden direkt in R erstellt.

2. «Einfache» Statistiken

Im Laufe ihres Bestehens publizierte die Informationspraxis 83 Artikel – Editorials eingeschlossen – in vierzehn Ausgaben. (Dabei wurden Ausgaben ab einem bestimmten Zeitpunkt «laufend» publiziert, also alle Beiträge wurden publiziert, wenn sie fertig waren, aber alle halben Jahre wurden die Ausgaben «abgeschlossen».) Die Verteilung der Beiträge über die Jahre ergibt sich aus der folgenden Graphik.

Dabei zeigt sich, dass die Zahl der Beiträge über die Ausgaben ungleich verteilt war. Erstaunlich ist vielleicht, dass es keine Trend dahin gibt, dass in den späteren Ausgaben weniger Texte veröffentlicht wurden, als in den früheren. Die kürzeste Ausgabe (2/2019) mit einem Text erschien fast in der Mitte der «Laufzeit» der Zeitschrift.

Insgesamt wurden diese Beiträge von 176 Autor*innen verantwortet, oft in Teams. Allerdings publizierten die meisten nur einmal. Es gab ein gewisses «Kernteam»: Stellt man nur diejenigen Autor*innen da, die mindestens dreimal publizierten, zeigt sich dies direkt. Dabei muss man beachten, dass drei der «Hauptautor*innen» unter diesen acht direkt der Redaktion angehörten, also auch redaktionelle Beiträge verantworten. (Etwas überraschend (für mich) war ich der Autor mit den meisten Publikationen, der nicht aus dem Kreis der Redaktion stammt. Das war nicht so geplant.)

| index | meta_data_content | n |

|---|---|---|

| 1 | Christian Hauschke | 14 |

| 2 | Karsten Schuldt | 8 |

| 3 | Rudolf Mumenthaler | 7 |

| 4 | Gabriele Fahrenkrog | 6 |

| 5 | Graham Triggs | 3 |

| 6 | Grischa Fraumann | 3 |

| 7 | Lambert Heller | 3 |

| 8 | Tatiana Walther | 3 |

| 9 | Adrian Pohl | 2 |

| 10 | Armin Talke | 2 |

| 11 | Arvid Deppe | 2 |

| 12 | Bernhard Mittermaier | 2 |

| 13 | Christian Mathieu | 2 |

| 14 | Daniel Schunk | 2 |

| 15 | Dörte Böhner | 2 |

| 16 | Fabian Steeg | 2 |

| 17 | Felix Lohmeier | 2 |

| 18 | Nicole Eichenberger | 2 |

| 19 | Pascal Christoph | 2 |

| 20 | Ute Engelkenmeier | 2 |

| 21 | Alessandro Blasetti | 1 |

| 22 | Alexander Grossmann | 1 |

| 23 | Alexandra Jobmann | 1 |

| 24 | Alexandra Svantje Linhart | 1 |

| 25 | Aloys Krieg | 1 |

| 26 | Andrea Hofmann | 1 |

| 27 | Andreas Ledl | 1 |

| 28 | Anette Cordts | 1 |

| 29 | Angela Oehler | 1 |

| 30 | Anita Eppelin | 1 |

| 31 | Ann Christin Wild | 1 |

| 32 | Azra Bekiri | 1 |

| 33 | Barbara Grossmann | 1 |

| 34 | Barbara Heindl | 1 |

| 35 | Barbara Knorn | 1 |

| 36 | Beat Mattmann | 1 |

| 37 | Belinda Jopp | 1 |

| 38 | Berfu Erdogan | 1 |

| 39 | Bernard Bekavac | 1 |

| 40 | Bruno Wüthrich | 1 |

| 41 | Christian Erlinger | 1 |

| 42 | Christian Kaier | 1 |

| 43 | Christian Koller | 1 |

| 44 | Christian Schneevogt | 1 |

| 45 | Christian Wilke | 1 |

| 46 | Christina Riesenweber | 1 |

| 47 | Christina Schmitz | 1 |

| 48 | Christof Rodejohann | 1 |

| 49 | Christoph Hornung | 1 |

| 50 | Christopher Hanna Johnson | 1 |

| 51 | Claudia Frick | 1 |

| 52 | Colette Knight | 1 |

| 53 | Corinna Haas | 1 |

| 54 | Cristina Magder | 1 |

| 55 | Dagmar Schnittker | 1 |

| 56 | Daniel Brenn | 1 |

| 57 | Daniel Beucke | 1 |

| 58 | Daniel Fischer | 1 |

| 59 | Daniel Hürlimann | 1 |

| 60 | Daniel Nüst | 1 |

| 61 | Denise Sievers | 1 |

| 62 | Diana Hamasur | 1 |

| 63 | Dominic Göhring | 1 |

| 64 | Dominik Feldschnieders | 1 |

| 65 | Dorothea Strecker | 1 |

| 66 | Ebru Kurtar | 1 |

| 67 | Eckhart Arnold | 1 |

| 68 | Elena Liventsova | 1 |

| 69 | Elias Entrup | 1 |

| 70 | Elke Dittmer | 1 |

| 71 | Erich Grevelding | 1 |

| 72 | Fabian Gail | 1 |

| 73 | Frank Waldschmidt-Dietz | 1 |

| 74 | Franziska Altemeier | 1 |

| 75 | Gary Seitz | 1 |

| 76 | Gudrun Nelson-Busch | 1 |

| 77 | Heidi Meyer | 1 |

| 78 | Heinz-Jürgen Bove | 1 |

| 79 | Heribert Nacken | 1 |

| 80 | Hervé L’Hours | 1 |

| 81 | Ina Blümel | 1 |

| 82 | Indra Heinrich | 1 |

| 83 | Irene Barbers | 1 |

| 84 | Jakob Voß | 1 |

| 85 | Jan Jäger | 1 |

| 86 | Jana Hentschke | 1 |

| 87 | Jana Mersmann | 1 |

| 88 | Jennifer Wiegand | 1 |

| 89 | Jens Ambacher | 1 |

| 90 | Jens Bemme | 1 |

| 91 | Jens Kösters | 1 |

| 92 | Jin Chei | 1 |

| 93 | Joanna Einbock | 1 |

| 94 | Jochen Haug | 1 |

| 95 | Johannes Hafner | 1 |

| 96 | Jonas Wäber | 1 |

| 97 | Jürgen Enge | 1 |

| 98 | Katharina Schulz | 1 |

| 99 | Kim Peters | 1 |

| 100 | Laura Bode | 1 |

| 101 | Laura Isbanner | 1 |

| 102 | Lea Maria Ferguson | 1 |

| 103 | Leander Seige | 1 |

| 104 | Marcel Wrzesinski | 1 |

| 105 | Marco Humbel | 1 |

| 106 | Marina Unger | 1 |

| 107 | Mark Vetter | 1 |

| 108 | Markus Trapp | 1 |

| 109 | Markus Putnings | 1 |

| 110 | Markus Trapp | 1 |

| 111 | Martin Munke | 1 |

| 112 | Martin Wollschläger-Tigges | 1 |

| 113 | Márton Villányi | 1 |

| 114 | Matti Stöhr | 1 |

| 115 | Maxi Kindling | 1 |

| 116 | Melis Rufaioglu | 1 |

| 117 | Meltem Dincer | 1 |

| 118 | Michaela Voigt | 1 |

| 119 | Nadin Kroll | 1 |

| 120 | Nele Leiner | 1 |

| 121 | Nicolas Bach | 1 |

| 122 | Nicole Petri | 1 |

| 123 | Niels Taubert | 1 |

| 124 | Nina Schönfelder | 1 |

| 125 | Nina Weisweiler | 1 |

| 126 | Oliver Sievi | 1 |

| 127 | Pascal Ngoc Phu Tu | 1 |

| 128 | Paul Vierkant | 1 |

| 129 | Petra Kohorst | 1 |

| 130 | Petra Schön | 1 |

| 131 | Philipp Zumstein | 1 |

| 132 | Qazi Asim Ijaz Ahmad | 1 |

| 133 | Ralf Stockmann | 1 |

| 134 | Regina Retter | 1 |

| 135 | Remziye Yildirimer | 1 |

| 136 | Robert Zepf | 1 |

| 137 | Roberto Cozatl | 1 |

| 138 | Romy Stelter | 1 |

| 139 | Ronnie Vogt | 1 |

| 140 | Rouven Schabinger | 1 |

| 141 | Ruth Schaffer Wüthrich | 1 |

| 142 | Sabine Stummeyer | 1 |

| 143 | Sabine Thänert | 1 |

| 144 | Sabrina Zaugg | 1 |

| 145 | Salome Zehnder | 1 |

| 146 | Sandra Golda | 1 |

| 147 | Sarah Dellmann | 1 |

| 148 | Sebastian Meyer | 1 |

| 149 | Seta Štuhec | 1 |

| 150 | Sigrid Freudl | 1 |

| 151 | Simon Schultze | 1 |

| 152 | Sinan Meral | 1 |

| 153 | Sonja Rosenberger | 1 |

| 154 | Sonja Schulze | 1 |

| 155 | Sophie Schneider | 1 |

| 156 | Stefan Bielesch | 1 |

| 157 | Stefan Müller | 1 |

| 158 | Stefan Schmeja | 1 |

| 159 | Stefanie Hanneken | 1 |

| 160 | Stefanie Spiegelberg | 1 |

| 161 | Steffi Grimm | 1 |

| 162 | Steffi Schulz | 1 |

| 163 | Susann Özüyaman | 1 |

| 164 | Susanne Baudisch | 1 |

| 165 | Svantje Lilienthal | 1 |

| 166 | Sylvia Hulin | 1 |

| 167 | Tabea Lurk | 1 |

| 168 | Tamara Mansaray | 1 |

| 169 | Thomas Kahlisch | 1 |

| 170 | Thomas Mutschler | 1 |

| 171 | Tim Schumann | 1 |

| 172 | Tina Grahl | 1 |

| 173 | Tracy Hoffmann | 1 |

| 174 | Ulrike Kändler | 1 |

| 175 | Vrushali Wyssmann | 1 |

| 176 | Wolf Christoph Seifert | 1 |

Ohne Vergleich mit anderen Zeitschriften ist nicht klar, wie man diese Werte interpretieren soll. Aber es scheint, als wenn es nicht einfach war, Autor*innen zu mehr als einem Beitrag zu bewegen.

Die Beiträge wurden in der Informationspraxis in fünf verschiedenen Rubriken veröffentlicht: Fachbeiträge, Kurzberichte, Berichte / Kritik, Editorial und Preprints. Diese Kategorien sind in dem Metadaten hinterlegt und lassen sich deshalb auch darstellen.

Sichtbar wird hier, dass die Fachbeiträge fast 50% darstellten, die Informationspraxis also als Fachzeitschrift gelten kann. Gleichzeitig fällt auf, dass die Zeitschrift oft darauf verzichtete, ein eigenständiges Editorial zu publizieren. Im Gegensatz zu anderen Zeitschriften, die dies in jeder Ausgabe tun, passierte dies nur manchmal.

Alle Beiträge wurden mit Keywords ausgezeichnet, insgesamt 104. Allerdings helfen diese Keywords nicht dabei, Trends bei den Themen, über die publiziert wurde, zu identifizieren. Gerade einmal vier von ihnen wurden mehr als einmal benutzt.

| index | meta_data_content | n |

|---|---|---|

| 1 | Open Access | 5 |

| 2 | DFG | 2 |

| 3 | Digitalisierung | 2 |

| 4 | Open-Access-Transformation | 2 |

| 5 | #vBIB20 | 1 |

| 6 | #vBIB21 | 1 |

| 7 | 3D-Digitalisierung | 1 |

| 8 | Arbeitsthemen und -aufträge | 1 |

| 9 | Article Processing Charge | 1 |

| 10 | Bericht | 1 |

| 11 | Bewegungsbuch | 1 |

| 12 | Bibliotheks-IT | 1 |

| 13 | Bibliotheksnutzung | 1 |

| 14 | Bibliotheksstatistik | 1 |

| 15 | Book Sprint | 1 |

| 16 | Citizen Science | 1 |

| 17 | Community | 1 |

| 18 | Corona | 1 |

| 19 | Corona-Virus | 1 |

| 20 | COVID-19 | 1 |

| 21 | Datenkompetenz | 1 |

| 22 | Diamond Open Access | 1 |

| 23 | Digitalisierungsstrategie | 1 |

| 24 | eBooks | 1 |

| 25 | Elektronisches Publizieren | 1 |

| 26 | Erfahrungsbericht | 1 |

| 27 | Fachzeitschrift | 1 |

| 28 | FID | 1 |

| 29 | Fluide Bibliothek, Aufstellungssystematik, Dynamisches Bestandsmanagement | 1 |

| 30 | Forschungsdaten | 1 |

| 31 | Forschungsdatenrepositorien | 1 |

| 32 | Fortbildung | 1 |

| 33 | Geistes- und Sozialwissenschaften | 1 |

| 34 | Geschäftsmodell | 1 |

| 35 | grüner Weg | 1 |

| 36 | Hochschulbibliotheken | 1 |

| 37 | Hochschulbildung | 1 |

| 38 | Indikatoren | 1 |

| 39 | Informationskompetenz | 1 |

| 40 | Ingenieurwissenschaft | 1 |

| 41 | Interne Wissenschaftskommunikation | 1 |

| 42 | Kollaboration | 1 |

| 43 | Konferenz | 1 |

| 44 | Konferenzorganisation | 1 |

| 45 | Konferenzplanung | 1 |

| 46 | Landesbibliothek | 1 |

| 47 | Landeskunde | 1 |

| 48 | Linked Open Data | 1 |

| 49 | Living Handbook | 1 |

| 50 | Lockdown | 1 |

| 51 | Methoden | 1 |

| 52 | Metriken | 1 |

| 53 | Moderation | 1 |

| 54 | Netzwerkanalyse | 1 |

| 55 | Nutzerstudien | 1 |

| 56 | Öffentliche Bibliotheken | 1 |

| 57 | Open-Access-Beratung | 1 |

| 58 | Open-Access-Finanzierung | 1 |

| 59 | Open-Access-Publizieren | 1 |

| 60 | Open-Access-Zeitschriften | 1 |

| 61 | Open Access Monitoring | 1 |

| 62 | Open Access Publizieren | 1 |

| 63 | Open Access Transformation | 1 |

| 64 | Open Educational Resources (OER) | 1 |

| 65 | Open Journal Systems | 1 |

| 66 | Open Peer-Review | 1 |

| 67 | Open Science | 1 |

| 68 | Peer-Review | 1 |

| 69 | Präsentation | 1 |

| 70 | Predatory Journals | 1 |

| 71 | Preprint | 1 |

| 72 | Promovierende | 1 |

| 73 | Publikationsfonds | 1 |

| 74 | Publikationskompetenz | 1 |

| 75 | Qualitätssicherung | 1 |

| 76 | quality assurance | 1 |

| 77 | Recommender | 1 |

| 78 | Regionalbibliothek | 1 |

| 79 | Regionalbibliotheken | 1 |

| 80 | Repositorium | 1 |

| 81 | research data | 1 |

| 82 | research data repositories | 1 |

| 83 | Responsible metrics | 1 |

| 84 | Sachsen | 1 |

| 85 | Sachsen-Anhalt | 1 |

| 86 | Scholar-Led Journals | 1 |

| 87 | Scholarly Communication | 1 |

| 88 | Services | 1 |

| 89 | Social Media | 1 |

| 90 | Szientometrie | 1 |

| 91 | textuelle Materialität | 1 |

| 92 | Thüringer Universitäts- und Landesbibliothek Jena | 1 |

| 93 | Transformation | 1 |

| 94 | 1 | |

| 95 | Umfrage | 1 |

| 96 | Visualisierungen | 1 |

| 97 | VIVO, Forschungsinformationen, Forschungsinformationssystem | 1 |

| 98 | VIVO, Forschungsinformationen, Forschungsinformationssystem, Ausbildung, Ontologie, Linked Data | 1 |

| 99 | Weiterbildung | 1 |

| 100 | Wiki | 1 |

| 101 | Wissenschaftliches Publizieren | 1 |

| 102 | Workflowentwicklung | 1 |

| 103 | Zusammenarbeit | 1 |

| 104 | Zweitveröffentlichungsservice | 1 |

Wir müssen uns also, um mehr über die Inhalte zu erfahren (ohne gleich alle Beiträge zu lesen), dem Textmining – also praktisch der statistischen Auswertung der Wortverteilung – zuwenden.

3. Textmining – einfach

Für Textmining wird immer Text – in unserem Fall alle in der Zeitschrift erschienen Beiträge – als Datenbasis für statistische Auswertungen verwendet. Dafür ist es notwendig, sie in ein Format zu bringen, dass nur aus Text besteht. Dies funktioniert mittels des im Abschnitt (2) beschriebenen Weges aber schnell, fast schon erschreckende schnell: Die Informationspraxis war eine Zeitschrift, an der über acht Jahre lang von vielen Menschen gearbeitet wurde – aber in etwas weniger als 70 Sekunden sind alle diese Metadaten und Artikel heruntergeladen, umgewandelt und für die weitergehende Analyse aufbereitet.

Was damit möglich ist, ist aber erst einmal eine einfache Auswertung der Worte und Wortverbindungen, die in den Artikeln vorkommen. Die Idee dahinter ist, dass aus diesem Vorkommen unterschwellige Themen gelesen werden können – also beispielsweise inhaltliche Gemeinsamkeiten zwischen den Beiträgen, die einzelnen Autor*innen gar nicht auffallen. (Es hilft, dass alle Artikel hier in der gleichen Sprache – dem Deutschen, wenn auch mit leichten Varianten – publiziert wurden. Das macht es möglich, einfach die gleiche Statistik für alle Dokumente zu erstellen und diese zusammenzufassen.)

Zuerst können wir uns eine Liste anschauen, welche die Dokumente (also unsere Beiträge) und ihre statistischen Eigenschaften zusammen darstellt. In der ersten Spalte findet sich die ID der Artikel, in der zweiten die Anzahl der Zeichen, in der dritten die Zahl der Sätze (gezählt nach den Satzendzeichen), in der vierten die der Tokens (zusammenhängende Buchstabenfolgen, also oft Worte, aber auch Emoticons oder so.) und in den folgenden Spalten die jeweilige Zahl weiterer Zeichenketten.

| index | document | chars | sents | tokens | types | puncts | numbers | symbols | urls | tags | emojis |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | [1] - Karsten Schuldt (202 | 42,070 | 298 | 6,932 | 1,420 | 1,019 | 233 | 25 | 27 | 0 | 0 |

| 2 | [2] - Stefan Schmeja, Ulri | 15,907 | 113 | 2,488 | 896 | 445 | 57 | 5 | 26 | 1 | 0 |

| 3 | [3] - Frank Waldschmidt-Di | 16,106 | 124 | 2,590 | 1,009 | 354 | 53 | 3 | 18 | 39 | 0 |

| 4 | [4] - Anette Cordts, Elias | 23,398 | 157 | 3,412 | 1,231 | 536 | 41 | 3 | 21 | 0 | 0 |

| 5 | [5] - Maxi Kindling, Dorot | 18,456 | 123 | 2,992 | 829 | 410 | 37 | 0 | 9 | 0 | 0 |

| 6 | [6] - Nicolas Bach (2022). | 38,517 | 233 | 5,847 | 1,779 | 670 | 60 | 19 | 44 | 0 | 0 |

| 7 | [7] - Tina Grahl (2021). S | 37,725 | 298 | 5,685 | 1,533 | 983 | 163 | 0 | 15 | 0 | 0 |

| 8 | [8] - Sarah Dellmann, Arvi | 43,978 | 323 | 6,827 | 1,969 | 1,266 | 151 | 1 | 27 | 1 | 0 |

| 9 | [9] - Berfu Erdogan, Chris | 17,405 | 101 | 2,484 | 930 | 289 | 29 | 0 | 11 | 0 | 0 |

| 10 | [10] - Grischa Fraumann, Ch | 17,265 | 118 | 2,702 | 1,007 | 616 | 62 | 5 | 19 | 0 | 0 |

| 11 | [11] - Christian Hauschke, | 20,680 | 175 | 3,028 | 1,143 | 555 | 82 | 7 | 41 | 0 | 0 |

| 12 | [12] - Jana Madlen Schütte | 13,186 | 76 | 1,794 | 669 | 281 | 34 | 0 | 17 | 0 | 0 |

| 13 | [13] - Thomas Mutschler (20 | 36,967 | 240 | 5,075 | 1,543 | 715 | 97 | 0 | 29 | 0 | 0 |

| 14 | [14] - Roberto Cozatl, Dani | 38,129 | 220 | 5,278 | 1,646 | 670 | 115 | 20 | 70 | 0 | 0 |

| 15 | [15] - Wolf Christoph Seife | 51,474 | 308 | 7,707 | 1,751 | 1,408 | 226 | 2 | 40 | 0 | 0 |

| 16 | [16] - Martin Munke, Daniel | 68,518 | 567 | 10,251 | 2,871 | 2,165 | 467 | 9 | 131 | 0 | 0 |

| 17 | [17] - Colette Knight, Tama | 30,556 | 204 | 4,535 | 1,403 | 654 | 65 | 0 | 32 | 0 | 0 |

| 18 | [18] - Markus Putnings (202 | 8,152 | 62 | 1,230 | 591 | 236 | 20 | 3 | 36 | 0 | 0 |

| 19 | [19] - Irene Barbers, Sonja | 54,159 | 381 | 7,756 | 2,210 | 1,086 | 552 | 23 | 104 | 0 | 0 |

| 20 | [20] - Stefanie Hanneken, A | 49,859 | 318 | 7,060 | 2,050 | 1,024 | 128 | 26 | 44 | 0 | 0 |

| 21 | [21] - Claudia Frick (2020) | 42,176 | 295 | 6,705 | 1,866 | 1,413 | 195 | 11 | 91 | 0 | 0 |

| 22 | [22] - Christina Riesenwebe | 8,084 | 65 | 1,297 | 483 | 181 | 12 | 1 | 5 | 0 | 0 |

| 23 | [23] - Franziska Altemeier, | 19,557 | 180 | 2,944 | 977 | 588 | 82 | 2 | 20 | 0 | 0 |

| 24 | [24] - Jana Hentschke, Sylv | 21,702 | 139 | 3,172 | 1,172 | 378 | 53 | 0 | 5 | 0 | 0 |

| 25 | [25] - Jens Bemme (2020). # | 29,603 | 180 | 4,314 | 1,442 | 831 | 79 | 2 | 78 | 10 | 0 |

| 26 | [26] - Stefanie Spiegelberg | 51,568 | 351 | 7,739 | 2,000 | 1,255 | 166 | 0 | 70 | 0 | 0 |

| 27 | [27] - Sophie Schneider (20 | 52,299 | 379 | 8,184 | 2,139 | 1,696 | 231 | 25 | 101 | 22 | 0 |

| 28 | [28] - Heinz-Jürgen Bove, J | 40,869 | 194 | 5,820 | 2,072 | 631 | 45 | 13 | 20 | 4 | 0 |

| 29 | [29] - Heinz-Jürgen Bove, J | 40,651 | 192 | 5,754 | 2,051 | 624 | 41 | 14 | 21 | 4 | 0 |

| 30 | [30] - Barbara Knorn, Erich | 9,314 | 68 | 1,312 | 554 | 191 | 25 | 0 | 9 | 0 | 0 |

| 31 | [31] - Karsten Schuldt (202 | 72,133 | 703 | 12,148 | 2,720 | 2,603 | 559 | 16 | 38 | 0 | 0 |

| 32 | [32] - Christian Mathieu (2 | 16,174 | 106 | 2,319 | 919 | 457 | 41 | 11 | 18 | 0 | 0 |

| 33 | [33] - Christian Hauschke ( | 43,448 | 455 | 7,200 | 2,239 | 1,666 | 304 | 5 | 74 | 0 | 0 |

| 34 | [34] - Alessandro Blasetti, | 95,594 | 633 | 13,598 | 3,098 | 2,381 | 331 | 22 | 128 | 1 | 0 |

| 35 | [35] - Fabian Steeg, Adrian | 25,852 | 147 | 3,844 | 1,207 | 628 | 34 | 15 | 59 | 0 | 0 |

| 36 | [36] - Nicole Eichenberger | 32,387 | 278 | 4,723 | 1,561 | 886 | 101 | 1 | 46 | 0 | 0 |

| 37 | [37] - Sabine Thänert, Mari | 21,651 | 143 | 3,057 | 1,074 | 450 | 84 | 1 | 85 | 0 | 0 |

| 38 | [38] - Christian Erlinger ( | 16,314 | 124 | 2,302 | 931 | 338 | 86 | 0 | 30 | 0 | 0 |

| 39 | [39] - Gabriele Fahrenkrog, | 27,207 | 154 | 3,763 | 1,174 | 495 | 81 | 3 | 39 | 0 | 0 |

| 40 | [40] - Christian Hauschke, | 20,719 | 142 | 2,929 | 1,066 | 465 | 42 | 1 | 30 | 0 | 0 |

| 41 | [41] - Joanna Einbock, Chri | 39,144 | 271 | 5,458 | 1,681 | 839 | 147 | 2 | 43 | 0 | 0 |

| 42 | [42] - Adrian Pohl, Fabian | 35,353 | 243 | 5,387 | 1,553 | 929 | 71 | 2 | 63 | 2 | 0 |

| 43 | [43] - Oliver Sievi, Andrea | 21,239 | 136 | 3,045 | 1,104 | 474 | 57 | 21 | 49 | 0 | 0 |

| 44 | [44] - Christian Hauschke, | 16,465 | 151 | 2,468 | 940 | 467 | 61 | 15 | 38 | 0 | 0 |

| 45 | [45] - Karsten Schuldt, Azr | 45,310 | 279 | 6,895 | 1,829 | 1,048 | 103 | 4 | 26 | 0 | 0 |

| 46 | [46] - Karsten Schuldt, Rud | 71,941 | 536 | 11,904 | 2,545 | 2,182 | 292 | 24 | 95 | 0 | 0 |

| 47 | [47] - Jakob Voß, Laura Bod | 19,123 | 139 | 2,837 | 1,011 | 407 | 85 | 9 | 34 | 0 | 0 |

| 48 | [48] - Nicole Eichenberger, | 23,449 | 140 | 3,852 | 1,047 | 459 | 49 | 0 | 28 | 0 | 0 |

| 49 | [49] - Jana Mersmann, Chris | 17,006 | 130 | 2,481 | 962 | 413 | 85 | 2 | 25 | 0 | 0 |

| 50 | [50] - Christian Wilke, Reg | 20,722 | 122 | 2,919 | 1,172 | 428 | 55 | 0 | 31 | 0 | 0 |

| 51 | [51] - Gabriele Fahrenkrog, | 10,127 | 65 | 1,367 | 634 | 175 | 12 | 0 | 7 | 0 | 0 |

| 52 | [52] - Eckhart Arnold, Stef | 65,296 | 376 | 10,122 | 2,487 | 1,616 | 107 | 9 | 121 | 0 | 0 |

| 53 | [53] - Salome Zehnder (2017 | 23,176 | 210 | 3,770 | 1,218 | 693 | 101 | 1 | 21 | 0 | 0 |

| 54 | [54] - Christian Koller (20 | 41,107 | 261 | 5,913 | 1,956 | 959 | 189 | 43 | 74 | 0 | 0 |

| 55 | [55] - Marco Humbel (2017). | 39,265 | 390 | 6,087 | 1,595 | 1,137 | 223 | 2 | 83 | 0 | 0 |

| 56 | [56] - Tabea Lurk, Jürgen E | 36,607 | 310 | 5,634 | 1,950 | 1,318 | 130 | 13 | 96 | 0 | 0 |

| 57 | [57] - Christian Kaier (201 | 28,694 | 204 | 4,087 | 1,332 | 776 | 100 | 4 | 28 | 0 | 0 |

| 58 | [58] - Márton Villányi (201 | 22,219 | 160 | 3,200 | 1,132 | 393 | 35 | 0 | 22 | 0 | 0 |

| 59 | [59] - Daniel Hürlimann, Al | 15,622 | 108 | 2,388 | 1,009 | 338 | 61 | 0 | 14 | 0 | 0 |

| 60 | [60] - Fabian Gail, Mark Ve | 66,758 | 427 | 9,837 | 2,663 | 1,331 | 115 | 2 | 51 | 0 | 0 |

| 61 | [61] - Christian Hauschke ( | 15,065 | 121 | 2,489 | 920 | 581 | 93 | 28 | 50 | 33 | 0 |

| 62 | [62] - Beat Mattmann (2016) | 24,222 | 169 | 3,619 | 1,328 | 637 | 86 | 1 | 32 | 0 | 0 |

| 63 | [63] - Karsten Schuldt (201 | 46,834 | 383 | 7,354 | 1,738 | 1,222 | 172 | 11 | 54 | 0 | 0 |

| 64 | [64] - Daniel Beucke, Arvid | 22,286 | 134 | 3,288 | 1,246 | 476 | 63 | 8 | 24 | 1 | 0 |

| 65 | [65] - Armin Talke (2016). | 17,614 | 105 | 2,580 | 969 | 356 | 40 | 2 | 17 | 0 | 0 |

| 66 | [66] - Dörte Böhner, Gabrie | 5,899 | 63 | 952 | 383 | 243 | 50 | 0 | 14 | 0 | 0 |

| 67 | [67] - Tim Schumann (2016). | 47,566 | 354 | 7,147 | 2,000 | 1,098 | 222 | 9 | 55 | 0 | 0 |

| 68 | [68] - Gabriele Fahrenkrog | 43,916 | 290 | 6,645 | 1,831 | 1,154 | 170 | 4 | 59 | 1 | 0 |

| 69 | [69] - Simon Schultze (2016 | 28,601 | 356 | 4,927 | 1,381 | 1,200 | 232 | 2 | 38 | 0 | 0 |

| 70 | [70] - Gary Seitz, Barbara | 14,816 | 116 | 2,272 | 829 | 376 | 84 | 1 | 21 | 0 | 0 |

| 71 | [71] - Andrea Hofmann, Chri | 12,391 | 115 | 1,912 | 788 | 340 | 61 | 3 | 16 | 0 | 0 |

| 72 | [72] - Martin Wollschläger- | 49,660 | 335 | 7,278 | 1,929 | 1,374 | 221 | 0 | 93 | 0 | 0 |

| 73 | [73] - Corinna Haas, Rudolf | 91,557 | 554 | 15,119 | 3,201 | 2,963 | 365 | 3 | 51 | 0 | 0 |

| 74 | [74] - Rudolf Mumenthaler, | 22,974 | 138 | 3,146 | 1,130 | 418 | 79 | 1 | 27 | 0 | 0 |

| 75 | [75] - Christian Hauschke, | 20,485 | 160 | 3,365 | 1,134 | 779 | 86 | 47 | 69 | 0 | 0 |

| 76 | [76] - Jens Ambacher, Gabri | 36,286 | 235 | 5,724 | 1,512 | 855 | 48 | 0 | 34 | 0 | 0 |

| 77 | [77] - Dörte Böhner, Gabrie | 5,967 | 39 | 907 | 452 | 105 | 2 | 0 | 0 | 0 | 0 |

| 78 | [78] - Rudolf Mumenthaler, | 29,193 | 188 | 4,190 | 1,249 | 583 | 47 | 0 | 25 | 0 | 0 |

| 79 | [79] - Susanne Baudisch, El | 148,307 | 921 | 22,126 | 4,585 | 3,772 | 687 | 11 | 240 | 0 | 0 |

| 80 | [80] - Alexandra Svantje Li | 33,637 | 298 | 5,224 | 1,407 | 861 | 201 | 0 | 43 | 0 | 0 |

| 81 | [81] - Bernhard Mittermaier | 77,525 | 455 | 11,945 | 2,817 | 1,899 | 481 | 42 | 158 | 0 | 0 |

| 82 | [82] - Ute Engelkenmeier (2 | 17,345 | 135 | 2,705 | 1,125 | 431 | 58 | 0 | 19 | 0 | 0 |

| 83 | [83] - Markus Trapp (2015). | 16,420 | 103 | 2,609 | 941 | 347 | 48 | 0 | 17 | 0 | 0 |

Wir sehen hier beispielsweise, dass es sehr unterschiedliche lange Beiträge gab; etwas, dass in Zeitschriften mit klaren Vorgaben für Artikel – im Bibliothekswesen vor allem die auch gedruckt erscheinenden praxisorientierten Zeitschriften – nicht vorkommen würde. Gleichzeitig zeigt sich, dass die Autor*innen auf #Tags und Emoticons verzichteten sowie andere Zeichen, als Text, nur sparsam einsetzten.

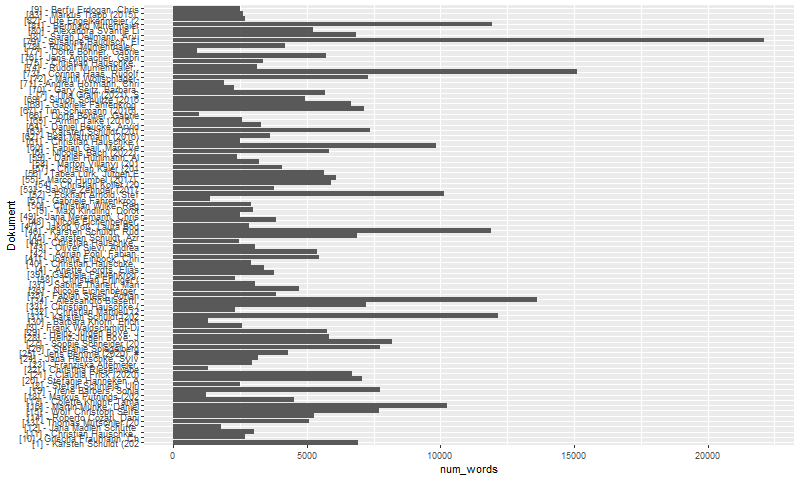

Die unterschiedliche Länge der Texte lässt sich auch (eingermassen) aus der folgenden Darstellung dieser Daten ablesen.

In einer weiteren Tabelle lässt sich ablesen, welche Worte am meisten verwendet wurden. Bei solchen Analysen finden sich – obgleich «Stoppwörter» standardmässig, also auch hier, aus diesen Statistiken entfernt werden – immer viele «Allgemeinworte». Relevant ist, die betreffenden, einen Korpus kennzeichnenden Worte herauszufiltern. Allgemeinworte in dieser Liste sind beispielsweise «dass», «wurde», «wurden». (In einem weiteren Schritt kann man diese Worte trunkieren – also auf ihren Wortstamm zurückführen, hier «wurde» und «wurden» auf «wurd». Aber das bedarf dann, die Ergebnisse noch mehr zu überprüfen, um herauszufinden, was richtig trunkiert wurden und was nicht. Etwas, das in diesem Experiment nicht getan wurde.)

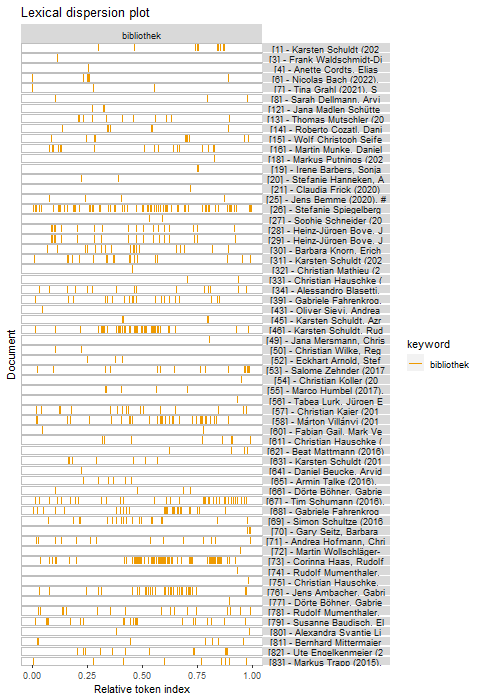

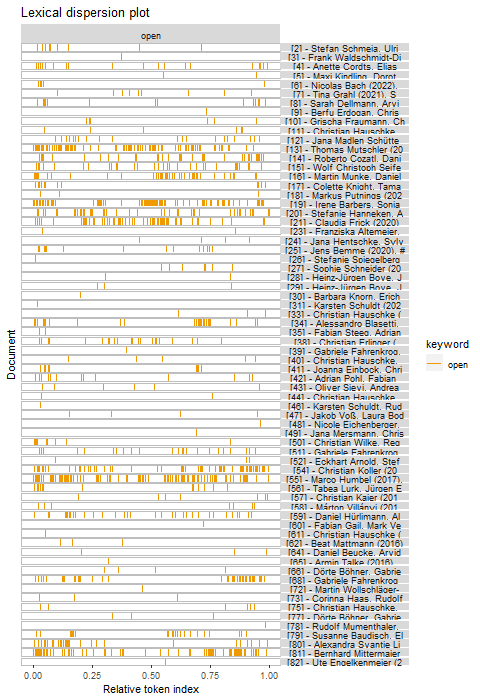

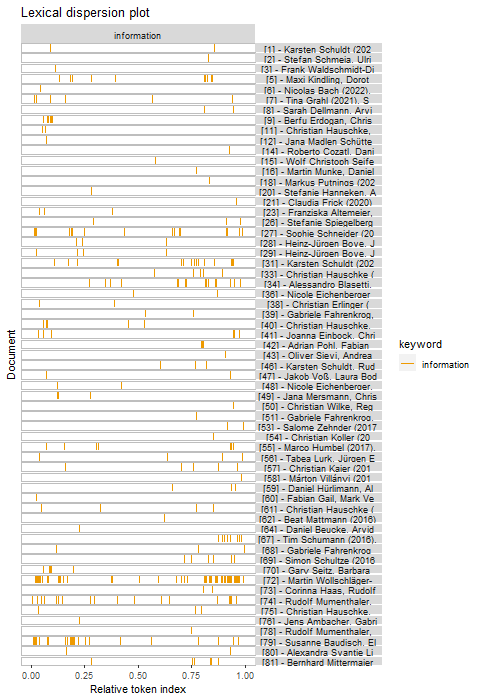

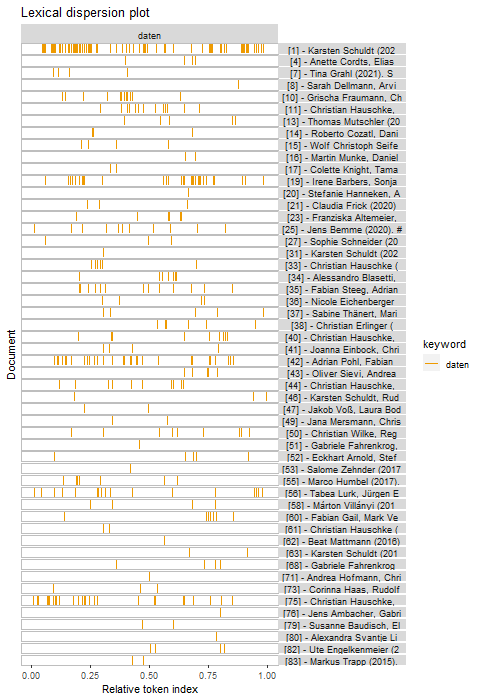

Für uns interessant sind Wort wie «bibliotheken» (1244-mal), «open» (1172-mal), «bibliothek» (756-mal), «access» (614-mal), «daten» (404-mal), «library» (360-mal), «data» (344-mal), «information» (331-mal), «online» (317-mal), «informationen» (264-mal), «menschen» (263-mal) oder «zugriff» (261-mal). Die Informationspraxis stammte aus dem Bibliothekswesen und dies war offenbar in den Artikeln, die bei ihr erschienen, auch prägend. Es wurde über Bibliotheken oder über Themen, die das Bibliothekswesen interessieren (Open Access, Information, Online, Menschen), geschrieben. (Erstaunlich ist, dass «archiv» nur 50-mal, «archive» 29-mal genannt wurde, allerdings auch noch eine Anzahl an Zusammensetzungen mit «Archiv».)

Wir können uns aus dieser Liste wieder Unterlisten ausgeben lassen und zum Beispiel schauen, ob, zum Beispiel, «Bibliothek» und «Information» rein als Begriff genutzt wurden oder in Zusammensetzungen.

Das scheint vielleicht etwas nach Spielerei (wir lernen halt, dass es zwar Zusammensetzungen gab, daneben die Begriffe allerdings grösstenteils «rein» verwendet wurden), aber sichtbar ist im zweiten Plot auch, dass der Zeitschriftenname selber recht oft verwendet wurde. (168-mal, wie die unterliegende Datentabelle zeigt.)

Für eine weitere Tabelle können wir uns den «collocations» (Kollokationen – was keine hilfreiche Übersetzung ist; es sind jeweils zwei zusammen stehende Worte), die gewisse allgemein verwendete Begrifflichkeiten anzeigen. Hier zeigt sich unter anderem, dass «Open Access» tatsächlich recht offen in den Beiträgen der Informationspraxis vorkam (566-mal).

4. Text Mining – (etwas) komplexer

Das quanteda Paket ermöglicht viele weitere Analysen. Das, was wir bislang gezeigt haben, ist eher nur ein Anfang. (Allerdings: Damit es sinnvoll ist, ist für viele Funktionen – ganz abgesehen davon, dass sie eine weitere Lernkurve bedeuten würden, für die bei diesem «Experiment» keine Zeit zur Verfügung stand – ein grösserer Datensatz notwendig.) Wir können aber zumindest zwei dieser Analysen durchführen.

Zuerst Keyword in Context (KWIC)-Tabellen. (Das erinnert Bibliothekar*innen vielleicht an ihren Katalogisierungsunterricht, wenn sie den noch hatten. Aber es ist etwas anderes.) In diesen Tabellen werden die jeweils gewählten Worte im Zusammenhang dargestellt. Die Länge des Zusammenhangs lässt sich selbstverständlich anpassen, aber hier haben wir die Standardeinstellung verwendet, die da heisst: je fünf Token vor und nach dem gesuchten Wort. In der erste Tabelle hier wird dies für «bibliothek» gezeigt. In dieser findet sich für jedes Vorkommen jeweils der Kontext, welcher das Wort umrahmt, zudem der Verweis auf den eigentlichen Text und eine Zeichenangabe, wo genau sich dieser Kontext vorkommt. Die Idee hinter diesen Tabelle ist es, jetzt einen Überblick darüber zu haben, was regelmässig im Zusammenhang mit dem gewählten Wort geschrieben wird. (In vielen Einleitungen zum Textmining wird dies anhand von politischen Reden vorgeführt, da ist dann sichtbar, was im Zusammenhang mit «umstrittenen» Begriffen gesagt wurde.)

| docname | from | to | pre | keyword | post | pattern |

|---|---|---|---|---|---|---|

| [1] - Karsten Schuldt (202 | 49 | 49 | dies auch für die Öffentlichen | Bibliotheken | in der Schweiz , Österreich | bibliothek* |

| [1] - Karsten Schuldt (202 | 62 | 62 | gilt , werden die betreffenden | Bibliotheksstatistiken | , soweit möglich , mit | bibliothek* |

| [1] - Karsten Schuldt (202 | 86 | 86 | COVID-19 Pandemie für die Öffentlichen | Bibliotheken | dieser drei Länder auch herausfordernd | bibliothek* |

| [1] - Karsten Schuldt (202 | 123 | 123 | zu Zuwächsen . COVID-19 , | Bibliotheksnutzung | , Bibliotheksstatistik , Öffentliche Bibliotheken | bibliothek* |

| [1] - Karsten Schuldt (202 | 125 | 125 | . COVID-19 , Bibliotheksnutzung , | Bibliotheksstatistik | , Öffentliche Bibliotheken An article | bibliothek* |

| [1] - Karsten Schuldt (202 | 128 | 128 | Bibliotheksnutzung , Bibliotheksstatistik , Öffentliche | Bibliotheken | An article , which explores | bibliothek* |

| [1] - Karsten Schuldt (202 | 301 | 301 | in welche die britischen Öffentlichen | Bibliotheken | durch die COVID-19 Pandemie geraten | bibliothek* |

| [1] - Karsten Schuldt (202 | 381 | 381 | eine allgemeine Krise von Öffentlichen | Bibliotheken | aufzeigen – oder vielleicht nur | bibliothek* |

| [1] - Karsten Schuldt (202 | 411 | 411 | deutschen , österreichischen und schweizerischen | Bibliotheksstatistik | durch . 1 ( Für | bibliothek* |

| [1] - Karsten Schuldt (202 | 747 | 747 | führen erstaunlicherweise keine Zahlen für | Bibliotheksbesuche | an . Diese sind ansonsten | bibliothek* |

| [1] - Karsten Schuldt (202 | 764 | 764 | es um die Arbeit von | Bibliotheken | geht und zudem einer , | bibliothek* |

| [1] - Karsten Schuldt (202 | 815 | 815 | , sich auch in den | Bibliotheken | im DACH-Raum zeigte . Für | bibliothek* |

| [1] - Karsten Schuldt (202 | 909 | 909 | Für eine vollständige Übersicht zu | Bibliotheken | im DACH-Raum wären Daten aus | bibliothek* |

| [1] - Karsten Schuldt (202 | 940 | 940 | auch bei den drei vorliegenden | Bibliotheksstatistiken | einige Einschränkungen zu beachten . | bibliothek* |

| [1] - Karsten Schuldt (202 | 959 | 959 | dann zur Verfügung gestellte deutsche | Bibliotheksstatistik | ist die umfangreichste und am | bibliothek* |

| [1] - Karsten Schuldt (202 | 975 | 975 | ) Sie umfasst die Öffentlichen | Bibliotheken | Deutschlands sowie die Wissenschaftlichen Bibliotheken | bibliothek* |

| [1] - Karsten Schuldt (202 | 980 | 980 | Bibliotheken Deutschlands sowie die Wissenschaftlichen | Bibliotheken | aus Deutschland und Österreich . | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,001 | 1,001 | nach Kriterien wie den gewünschten | Bibliothekstypen | , Jahren oder einzelnen Variablen | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,029 | 1,029 | dass eine ganze Anzahl von | Bibliotheken | für verschiedene Variablen keine Werte | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,117 | 1,117 | verstehen . 3 Die schweizerische | Bibliotheksstatik | wird vom Bundesamt für Statistik | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,144 | 1,144 | Diese Daten stehen für verschiedene | Bibliothekstypen | ( und bis 2019 auch | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,152 | 1,152 | bis 2019 auch für unterschiedliche | Bibliotheksgrössen | ) und noch einmal in | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,212 | 1,212 | . Zuvor wurden nicht alle | Bibliotheken | erfasst . Es fehlten solche | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,252 | 1,252 | diesen eine ganze Anzahl von | Bibliotheken | , die nicht für alle | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,275 | 1,275 | Eine wichtigere Einschränkung der schweizerischen | Bibliotheksstatik | im Bezug auf die hier | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,356 | 1,356 | . Die Daten der Österreichischen | Bibliotheksstatistik | werden , wie gesagt , | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,390 | 1,390 | auch bei den beiden anderen | Bibliotheksstatistiken | sind diese mit Vorsicht zu | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,438 | 1,438 | Auch meldeten nur sehr wenige | Bibliotheken | Daten zur “ Ausleihe ” | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,461 | 1,461 | Medien in den meisten dieser | Bibliotheken | durch zentrale Lizenzen für die | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,498 | 1,498 | 5 Für diese Statistiken erfassen | Bibliotheken | selbstständig ihre jeweiligen Daten und | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,530 | 1,530 | wohl davon ausgehen , dass | Bibliotheken | hier versuchen , ehrliche Antworten | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,547 | 1,547 | kann dies nicht . Die | Bibliotheksstatistiken | und damit auch Auswertungen wie | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,581 | 1,581 | möglich war , versucht die | Bibliotheken | nicht mitzubetrachten , die gleichzeitig | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,588 | 1,588 | mitzubetrachten , die gleichzeitig mehreren | Bibliothekstypen | angehören , also zum Beispiel | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,616 | 1,616 | schwierig zu bestimmen , welche | Bibliotheksnutzungen | sich auf welchen Bereich der | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,623 | 1,623 | auf welchen Bereich der jeweiligen | Bibliotheken | bezogen . Weiterhin ist zu | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,764 | 1,764 | österreichische und 7045 deutsche Öffentliche | Bibliotheken | . Anschliessend wurden die Fragen | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,919 | 1,919 | verwendet , also Daten von | Bibliotheken | , welche solche jeweils für | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,931 | 1,931 | drei Jahre angegeben hatten . | Bibliotheken | , welche beispielsweise erstmals für | bibliothek* |

| [1] - Karsten Schuldt (202 | 1,955 | 1,955 | beachtet , genauso wie solche | Bibliotheken | , die aus unterschiedlichen Gründen | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,010 | 2,010 | Angaben für die Besuche von | Bibliotheken | vorlagen und zu vermuten ist | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,098 | 2,098 | Ort – beispielsweise Neueröffnungen von | Bibliothek | – oder eventuell auch Datenfehler | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,496 | 2,496 | . Bei der Umstellung der | Bibliotheksstatistik | für die Daten ab 2020 | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,648 | 2,648 | Grossbritannien gab es für die | Bibliotheken | in den drei Ländern relativ | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,675 | 2,675 | Zeit , die von den | Bibliotheken | recht gut gemeistert wurden . | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,710 | 2,710 | sich am meisten auf Öffentliche | Bibliotheken | in Deutschland auswirkten , dann | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,725 | 2,725 | in Österreich und das die | Bibliotheken | in der Schweiz während der | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,790 | 2,790 | hier jeweils die Anzahl der | Bibliotheken | , bei denen sich eine | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,828 | 2,828 | . Während in Grossbritannien alle | Bibliotheken | eine Reduktion dieser Ausleihen berichteten | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,860 | 2,860 | sich sehr wohl immer auch | Bibliotheken | , die im Jahr 2020 | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,886 | 2,886 | zum Beispiel knapp 4400 Öffentliche | Bibliotheken | in Deutschland ( von rund | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,923 | 2,923 | ist der grösste Teil der | Bibliotheken | . Aber gleichzeitig ist dies | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,938 | 2,938 | Grossbritannien , wo die meisten | Bibliotheken | zwischen 61 % und 96 | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,969 | 2,969 | etwas mehr als 800 deutsche | Bibliotheken | 2020 bis zu 50 % | bibliothek* |

| [1] - Karsten Schuldt (202 | 2,988 | 2,988 | % -100 % und einige | Bibliotheken | sogar noch grössere Steigerungen meldeten | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,045 | 3,045 | In Österreich berichteten die meisten | Bibliotheken | von einem im Vergleich zu | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,064 | 3,064 | In der Schweiz konnten mehr | Bibliotheken | über eine Steigerung der Ausleihe | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,092 | 3,092 | Grenzen . Der Grossteil der | Bibliotheken | findet sich in der Bandbreite | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,120 | 3,120 | die Hälfte der allgemein öffentlichen | Bibliotheken | in der Schweiz 2020 die | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,189 | 3,189 | einmal einzugrenzen : Viele Öffentliche | Bibliotheken | lieferten keine kontinuierlichen Daten , | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,215 | 3,215 | Nicht klar ist , ob | Bibliotheken | stattdessen über regionale Konsortien für | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,235 | 3,235 | die betreffenden Werte für ihre | Bibliothek | dann aber ( entgegen der | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,313 | 3,313 | : Der grösste Teil der | Bibliotheken | berichtete von einer Steigerung von | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,338 | 3,338 | auch eine bemerkbare Minderheit von | Bibliotheken | , deren Daten eine Reduktion | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,385 | 3,385 | 10 Aber die meisten dieser | Bibliotheken | mit einem Rückgang dieser “ | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,412 | 3,412 | Daten zeigte sich in einigen | Bibliotheken | eine Reduktion solcher “ Ausleihen | bibliothek* |

| [1] - Karsten Schuldt (202 | 3,423 | 3,423 | ” . Die meisten britischem | Bibliotheken | berichteten aber über eine Steigerung | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,006 | 4,006 | . Zudem gab es auch | Bibliotheken | , welche mehr physische Bücher | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,055 | 4,055 | dass es auch in Deutschland | Bibliotheken | gab , die 2020 insgesamt | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,068 | 4,068 | . Aber doch weit mehr | Bibliotheken | , die eine kleine Steigerung | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,130 | 4,130 | ist , ob es für | Bibliotheken | überhaupt effizient ist , Lizenzen | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,204 | 4,204 | Lizenzkosten 2018 und 2020 der | Bibliotheken | , die dazu Angaben machten | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,227 | 4,227 | lässt sich sehen , dass | Bibliotheken | 2020 zumeist mehr Geld für | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,248 | 4,248 | beiden Ländern für die meisten | Bibliotheken | bis zu 50 % beträgt | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,274 | 4,274 | % -50 % ( 27 | Bibliotheken | ) , 50 % -100 | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,283 | 4,283 | % -100 % ( 28 | Bibliotheken | ) und 100 % -150 | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,292 | 4,292 | % -150 % ( 29 | Bibliotheken | ) streckte . Auffällig ist | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,304 | 4,304 | , dass die Zahl der | Bibliotheken | , welche einen Rückgang meldeten | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,336 | 4,336 | wie schon dargestellt , die | Bibliotheken | in der Schweiz und Deutschland | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,381 | 4,381 | zu verstehen , ob die | Bibliotheken | Geld effektiv für Lizenzen ausgeben | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,399 | 4,399 | der Zeit sinken , wenn | Bibliotheken | mit zunehmender Erfahrung eher die | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,615 | 4,615 | eine sehr kleine Anzahl von | Bibliotheken | . ) Die Zahlen sind | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,635 | 4,635 | Medienformen weiter höher . Deutsche | Bibliotheken | scheinen also grundsätzlich mit der | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,705 | 4,705 | nicht die Entwicklung der konkreten | Bibliotheksbesuche | . Gründe dafür geben sie | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,812 | 4,812 | wieder , dass die schweizerischen | Bibliotheken | die etwas besseren Zahlen erreichten | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,920 | 4,920 | vor allem die Besuche in | Bibliotheken | waren – im Gegensatz zu | bibliothek* |

| [1] - Karsten Schuldt (202 | 4,963 | 4,963 | dass die Situation für Öffentliche | Bibliotheken | zumindest im ersten Jahr der | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,095 | 5,095 | Was sichtbar wurde und für | Bibliotheken | in Zukunft relevant sein sollte | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,120 | 5,120 | obgleich die Besuche in den | Bibliotheken | massiv zurückgingen . Dies steht | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,129 | 5,129 | Dies steht entgegen der im | Bibliothekswesen | verbreiteten Vorstellung , dass der | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,136 | 5,136 | Vorstellung , dass der Raum | Bibliothek | eine immer grössere Bedeutung im | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,190 | 5,190 | die vor allem Medien aus | Bibliotheken | nutzen und den Personen , | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,201 | 5,201 | die vor allem den Raum | Bibliothek | nutzen , um zwei verschiedene | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,248 | 5,248 | mit Fragen zum Raum der | Bibliothek | geschieht . Der Unterschied der | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,291 | 5,291 | einer anhaltenden Krise des britischen | Bibliothekswesens | geschrieben , die vor allem | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,332 | 5,332 | Daten mit denen aus den | Bibliotheksstatistiken | anderer Länder zu vergleichen . | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,372 | 5,372 | DACH-Raum als auch Grossbritannien unterschiedlichen | Bibliothekskultur | wie beispielsweise Frankreich , Spanien | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,433 | 5,433 | entgegen steht allerdings , dass | Bibliotheksstatistiken | offenbar in jedem Land anders | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,477 | 5,477 | sollen . Zudem sind die | Bibliotheksstatistiken | und ihre Begleitdokumente – also | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,606 | 5,606 | schweizerischen , österreichischen und deutschen | Bibliotheksstatistiken | für die Jahr 2018 bis | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,617 | 5,617 | 2020 zeigte , dass Öffentlichen | Bibliotheken | durch die COVID-19 Pandemie nicht | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,658 | 5,658 | sollte Teil des Selbstbildes von | Bibliotheken | werden – nämlich , das | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,686 | 5,686 | , um die Daten der | Bibliotheksstatik | – die , wie dargestellt | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,771 | 5,771 | Definitionen der Variablen der Schweizerischen | Bibliothekenstatistik | : Grunddaten und Basisvariablen . | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,796 | 5,796 | Definitionen der Variablen der Schweizerischen | Bibliothekenstatistik | : Kurzfragebogen und Zusatzfragen . | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,822 | 5,822 | ? Die Situation der britischen | Bibliotheken | im Nachhall der Finanzkrise . | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,831 | 5,831 | Finanzkrise . 027.7 Zeitschrift für | Bibliothekskultur | 6 , 1 , 15-24 | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,853 | 5,853 | Über die unterschätzten Analogien von | Bibliothek | und öffentlichem Raum . Bibliothek | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,858 | 5,858 | Bibliothek und öffentlichem Raum . | Bibliothek | Forschung und Praxis 45 , | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,918 | 5,918 | Wohnzimmer : Ein Projekt zu | Bibliotheken | und Begegnungen im öffentlichen Raum | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,928 | 5,928 | Raum . BuB . Forum | Bibliothek | und Information 73 , 1 | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,961 | 5,961 | Martin 2021 . Statistik öffentlicher | Bibliotheken | : Österreichs Bibliotheken in der | bibliothek* |

| [1] - Karsten Schuldt (202 | 5,964 | 5,964 | Statistik öffentlicher Bibliotheken : Österreichs | Bibliotheken | in der Corona Pandemie . | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,008 | 6,008 | den britischen Public Libraries vergleichbare | Bibliothekstyp | wird in den Ländern des | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,032 | 6,032 | : In Deutschland als Öffentliche | Bibliothek | , in der Schweiz und | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,042 | 6,042 | und Liechtenstein als allgemein öffentliche | Bibliothek | und in Österreich teilweise als | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,053 | 6,053 | Bücherei und teilweise als öffentliche | Bibliothek | . In diesem Text wird | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,321 | 6,321 | von E-Books aus allgemein öffentlichen | Bibliotheken | 2018-2019 gibt . ↩ Der | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,354 | 6,354 | variable Auswertung ” der Deutschen | Bibliotheksstatistik | mit den in dieser Studie | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,371 | 6,371 | Jahre 2018-2020 für alle Öffentlichen | Bibliotheken | , die betreffenden Datenblätter der | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,378 | 6,378 | die betreffenden Datenblätter der schweizerischen | Bibliotheksstatistik | sowie die schon im gewünschten | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,391 | 6,391 | Verfügung gestellten Daten der Österreichischen | Bibliotheksstatistik | . Die Daten für die | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,413 | 6,413 | je eine für allgemein öffentliche | Bibliotheken | in Gemeinden mit mehr oder | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,441 | 6,441 | einfach möglich , weil alle | Bibliotheken | eine eindeutige ID besitzen , | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,467 | 6,467 | _inquiry = 115 . ↩ | Bibliotheken | im DACH-Raum – nicht nur | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,521 | 6,521 | sein , dass dies den | Bibliotheken | im DACH-Raum gegenüber jenen in | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,673 | 6,673 | 100 Prozent . Einige dieser | Bibliotheken | könnten auch zum Zeitpunkt des | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,686 | 6,686 | Daten für 2020 in die | Bibliotheksstatistik | keine Angaben zu dieser Variable | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,767 | 6,767 | sehr unerwarteten Ergebnisse in einzelnen | Bibliotheken | , eventuell aber auch Datenfehler | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,784 | 6,784 | Qualität der Daten in den | Bibliotheksstatistiken | des DACH-Raumes hilfreich . ↩ | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,832 | 6,832 | diesen Preisveränderung von für Öffentliche | Bibliotheken | sinnvollen Lizenzen einzubeziehen . ↩ | bibliothek* |

| [1] - Karsten Schuldt (202 | 6,850 | 6,850 | . Es gibt in den | Bibliotheksstatistiken | im DACH-Raum zum Beispiel auch | bibliothek* |

| [2] - Stefan Schmeja, Ulri | 1,151 | 1,151 | den TU9-Bibliotheken gemeinsam mit Schweizer | Bibliotheken | eine Umfrage zur Erfassung des | bibliothek* |

| [3] - Frank Waldschmidt-Di | 39 | 39 | die Beine , welche den | Bibliothekartag | in vielerlei Hinsicht ergänzte . | bibliothek* |

| [3] - Frank Waldschmidt-Di | 102 | 102 | event that complemented the “ | Bibliothekartag | ” in many ways . | bibliothek* |

| [3] - Frank Waldschmidt-Di | 295 | 295 | digitale Konferenz vom Berufsverband Information | Bibliothek | ( BIB ) und der | bibliothek* |

| [3] - Frank Waldschmidt-Di | 547 | 547 | Vergleich der #vBIB mit dem | Bibliothekartag | ( Bibtag ) ist natürlich | bibliothek* |

| [3] - Frank Waldschmidt-Di | 624 | 624 | Kundinnen und Kunden in den | Bibliotheken | vor Ort übertragen lässt . | bibliothek* |

| [3] - Frank Waldschmidt-Di | 641 | 641 | #vBIB20 diesmal nicht anstelle des | Bibliothekartages | statt , sondern ergänzend dazu | bibliothek* |

| [3] - Frank Waldschmidt-Di | 666 | 666 | nach meinem Vortrag auf dem | Bibliothekartag | zum Thema „ YouTube in | bibliothek* |

| [3] - Frank Waldschmidt-Di | 672 | 672 | zum Thema „ YouTube in | Bibliotheken | “ . Den hatte ich | bibliothek* |

| [3] - Frank Waldschmidt-Di | 872 | 872 | 2021 gab es gleich zwei | bibliothekarische | Mega-Events , den Bibliothekartag hybrid | bibliothek* |

| [3] - Frank Waldschmidt-Di | 876 | 876 | zwei bibliothekarische Mega-Events , den | Bibliothekartag | hybrid und die #vBIB rein | bibliothek* |

| [3] - Frank Waldschmidt-Di | 1,156 | 1,156 | zugleich in vorbildlicher Weise dem | bibliothekarischen | Auftrag nach , Wissen zu | bibliothek* |

| [3] - Frank Waldschmidt-Di | 1,188 | 1,188 | geplante Vortrag zu YouTube in | Bibliotheken | zog kurzerhand zur #vBIB um | bibliothek* |

| [3] - Frank Waldschmidt-Di | 1,211 | 1,211 | der Aus- und Weiterbildung in | Bibliotheken | “ und bei der #vBIB21 | bibliothek* |

| [3] - Frank Waldschmidt-Di | 1,228 | 1,228 | das Graswurzel-Netzwerk “ Tutorials in | Bibliotheken | ” in den Mittelpunkt . | bibliothek* |

| [3] - Frank Waldschmidt-Di | 1,420 | 1,420 | of Practice “ Agilität in | Bibliotheken | ” . Auch bei einer | bibliothek* |

| [3] - Frank Waldschmidt-Di | 1,803 | 1,803 | und den Kontakt in der | Bibliothekscommunity | aufrechtzuerhalten . Eine hilfreiche Möglichkeit | bibliothek* |

| [3] - Frank Waldschmidt-Di | 2,038 | 2,038 | auch für die Mitschnitte beim | Bibliothekartag | , wenn sie - was | bibliothek* |

| [3] - Frank Waldschmidt-Di | 2,145 | 2,145 | des Netzwerks “ Tutorials in | Bibliotheken | ” Gebrauch gemacht . Zu | bibliothek* |

| [3] - Frank Waldschmidt-Di | 2,267 | 2,267 | Weiterbildung und eine Ergänzung zum | Bibliothekartag | , der sich vor allem | bibliothek* |

| [4] - Anette Cordts, Elias | 863 | 863 | einem technischen Partner wie einer | Bibliothek | oder einem Fachinformationszentrum oder die | bibliothek* |

| [4] - Anette Cordts, Elias | 1,533 | 1,533 | , die sich vorrangig an | Bibliotheken | richten . Diese werden eine | bibliothek* |

| [4] - Anette Cordts, Elias | 1,635 | 1,635 | Open-Access-Zeitschriften und -Buchreihen durch wissenschaftliche | Bibliotheken | stellt eine Alternative zum dominanten | bibliothek* |

| [4] - Anette Cordts, Elias | 1,752 | 1,752 | sogenannte Pledgingphase , während der | Bibliotheken | und andere Akteur * innen | bibliothek* |

| [4] - Anette Cordts, Elias | 2,132 | 2,132 | ein Großteil der Teilnehmenden im | Bibliothekskontext | und in der Publikationsinfrastruktur verortet | bibliothek* |

| [6] - Nicolas Bach (2022). | 12 | 12 | April 2022 fand an der | Bibliothek | der TH Wildau der erste | bibliothek* |

| [6] - Nicolas Bach (2022). | 18 | 18 | der TH Wildau der erste | bibliothekarische | Book Sprint Deutschlands statt , | bibliothek* |

| [6] - Nicolas Bach (2022). | 38 | 38 | nachnutzbare Handbuch „ IT in | Bibliotheken | “ hervorging . Organisiert durch | bibliothek* |

| [6] - Nicolas Bach (2022). | 47 | 47 | Organisiert durch und für die | Bibliotheks-Community | , gefördert vom Open-Access-Publikationsfonds des | bibliothek* |

| [6] - Nicolas Bach (2022). | 122 | 122 | Sprint , Living Handbook , | Bibliotheks-IT | , Open Access Publizieren , | bibliothek* |

| [6] - Nicolas Bach (2022). | 292 | 292 | betitelte Handbuch “ IT in | Bibliotheken | ” wurde 2021 von Frank | bibliothek* |

| [6] - Nicolas Bach (2022). | 314 | 314 | Initiator des dort angesiedelten Master-Studiengangs | Bibliotheksinformatik | , und Anne Christensen , | bibliothek* |

| [6] - Nicolas Bach (2022). | 352 | 352 | auch offenes Handbuch für die | Bibliotheks-IT | existierte und sich das ändern | bibliothek* |

| [6] - Nicolas Bach (2022). | 386 | 386 | , dass im Geflecht der | Bibliotheks-IT | insbesondere dem Bibliotheksmanagementsystem ( BMS | bibliothek* |

| [6] - Nicolas Bach (2022). | 389 | 389 | Geflecht der Bibliotheks-IT insbesondere dem | Bibliotheksmanagementsystem | ( BMS ) eine zentrale | bibliothek* |

| [6] - Nicolas Bach (2022). | 419 | 419 | “ Einsatz von KI-Methoden in | Bibliotheken | ” ( Seeliger u . | bibliothek* |

| [6] - Nicolas Bach (2022). | 551 | 551 | der multiplen Themen aus der | Bibliotheks-IT | für das Handbuch mehrere Sprints | bibliothek* |

| [6] - Nicolas Bach (2022). | 830 | 830 | innen aus sämtlichen Sparten von | Bibliotheken | einzubinden , um die vielfältigen | bibliothek* |

| [6] - Nicolas Bach (2022). | 838 | 838 | um die vielfältigen Betrachtungsweisen der | Bibliotheks-IT | abzubilden ( Förderung von Sharing | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,047 | 1,047 | Expert * innen aus der | Bibliotheks-IT | angefragt , die gemeinsame Terminfindung | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,206 | 1,206 | Entscheider * innen in allen | Bibliothekssparten | sowie Studierende und Lehrende . | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,266 | 1,266 | ein Standardwerk zu IT in | Bibliotheken | noch fehlt und weil ein | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,349 | 1,349 | erstaunlich guten Ergebnissen . Im | Bibliotheksbereich | feiert der Book Sprint seine | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,369 | 1,369 | Übernachtung werden erstattet . Die | Bibliothek | der TH Wildau bietet einen | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,459 | 1,459 | mit 250.000 Einwohnern . Die | Bibliothek | besteht aus einer Zentrale und | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,499 | 1,499 | mit 500.000 Medieneinheiten . Die | Bibliothek | gehört einem Bibliotheksverbund an . | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,502 | 1,502 | . Die Bibliothek gehört einem | Bibliotheksverbund | an . Die Bibliothek plant | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,506 | 1,506 | einem Bibliotheksverbund an . Die | Bibliothek | plant einen Neubau , der | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,542 | 1,542 | Universitätsbibliothek . Sie hat keine | bibliothekarische | Vorbildung . Alicia Meyer : | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,550 | 1,550 | Alicia Meyer : Alicia studiert | Bibliotheksmanagement | und plant eine Masterarbeit , | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,582 | 1,582 | ist nebenberuflich Lehrbeauftragter für einen | bibliothekarischen | Studiengang . Die interne Kommunikation | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,650 | 1,650 | und der Präsentation auf dem | Bibliothekskongress | abzuarbeiten . Nach außen hin | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,756 | 1,756 | der Bezug zu dem Thema | Bibliotheks-IT | . Die überwiegende Mehrheit stammte | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,766 | 1,766 | stammte aus dem Umfeld wissenschaftlicher | Bibliotheken | und konnte auf langjährige Berufserfahrung | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,776 | 1,776 | Berufserfahrung zurückblicken . Aus öffentlichen | Bibliotheken | war hingegen nur eine Person | bibliothek* |

| [6] - Nicolas Bach (2022). | 1,789 | 1,789 | ebenso vonseiten der Studierenden des | Bibliothekswesens | . Mit letztendlich nur drei | bibliothek* |

| [6] - Nicolas Bach (2022). | 2,068 | 2,068 | Kemner-Heek , Leiterin der Abteilung | Bibliotheksmanagementsysteme | beim GBV , und Marshall | bibliothek* |

| [6] - Nicolas Bach (2022). | 2,080 | 2,080 | , weltweit bekannter Consultant für | Bibliothekstechnologie | , erklärten sich bereit , | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,184 | 3,184 | und der Vorstellung auf dem | Bibliothekskongress | 2022 aus . Die technische | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,678 | 3,678 | im Rahmen des 8 . | Bibliothekskongresses | 2022 in Leipzig durch die | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,785 | 3,785 | als studentischer Mitarbeiter in der | Bibliotheks-IT | einer großen Wissenschaftsorganisation Beiträge zu | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,791 | 3,791 | einer großen Wissenschaftsorganisation Beiträge zu | Bibliotheksmanagement- | und Discovery-Systemen für das Handbuch | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,801 | 3,801 | Handbuch “ Erfolgreiches Management von | Bibliotheken | und Informationseinrichtungen ” ( EMBI | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,825 | 3,825 | Darstellung für vorwiegend Führungskräfte in | Bibliotheken | brachte dabei aber mit sich | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,928 | 3,928 | dem Handbuch “ IT in | Bibliotheken | ” nun die Gelegenheit , | bibliothek* |

| [6] - Nicolas Bach (2022). | 3,997 | 3,997 | Weg , das Wissen der | Bibliotheks-IT | in Buchform zu transportieren . | bibliothek* |

| [6] - Nicolas Bach (2022). | 4,363 | 4,363 | Oberbegriffe wie “ Begriff ‚ | Bibliothekssystem | ‘ ” , “ Datenschutz | bibliothek* |

| [6] - Nicolas Bach (2022). | 4,401 | 4,401 | Rolle unserer Zielgruppe aus dem | Bibliothekswesen | ( siehe Personas in Abschnitt | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,002 | 5,002 | und Software Engineer bei einem | Bibliothekssoftwaredienstleister | , per Video zusammenschaltete , | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,028 | 5,028 | Sprints platzierte ich im DACH | Bibliothekswesen | Discord-Kanal Ankündigungen und informierte per | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,037 | 5,037 | informierte per E-Mail meine der | Bibliotheks-IT | nahestehenden Professoren über das Projekt | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,075 | 5,075 | als vergleichsweiser Neuling in der | Bibliotheks-IT | trotzdem alle der weiteren Anwesenden | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,215 | 5,215 | Sprint zum Handbuch IT in | Bibliothek | war für mich die bisher | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,246 | 5,246 | die ich bisher für das | Bibliothekswesen | zurückgelegt habe . Entsprechend empfand | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,591 | 5,591 | von uns geschriebenen Kapitel zu | Bibliotheksmanagementsystemen | erhielten . Im Nachhinein hat | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,654 | 5,654 | legen für ein Standardwerk der | Bibliotheks-IT | , bei dem jede * | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,695 | 5,695 | , für den vermutlich ersten | bibliothekarischen | Book Sprint in Deutschland nach | bibliothek* |

| [6] - Nicolas Bach (2022). | 5,757 | 5,757 | erfolgversprechenden Einsatz von KI in | Bibliotheken | . b.i.t.online 24 , 2 | bibliothek* |

| [7] - Tina Grahl (2021). S | 10 | 10 | GRAHL In einer Befragung der | Bibliothek | der TH Aschaffenburg wurde das | bibliothek* |

| [7] - Tina Grahl (2021). S | 451 | 451 | Hochschule Bayern 2020b ) . | Bibliotheken | an HAWs sollten daher Promovierende | bibliothek* |

| [7] - Tina Grahl (2021). S | 782 | 782 | wurde im Rahmen des Studiengangs | Bibliotheks- | und Informationswissenschaft ( MALIS ) | bibliothek* |

| [7] - Tina Grahl (2021). S | 1,568 | 1,568 | bestehenden Kurs- und Beratungsangeboten der | Bibliothek | wurde mit einer Likert-Skala mit | bibliothek* |

| [7] - Tina Grahl (2021). S | 1,855 | 1,855 | ( 8 ) , der | Bibliothekskatalog | ( 7 ) und Suchmaschinen | bibliothek* |

| [7] - Tina Grahl (2021). S | 3,147 | 3,147 | Informationen auf der Webseite der | Bibliothek | ( 5 ) . Es | bibliothek* |

| [7] - Tina Grahl (2021). S | 4,351 | 4,351 | Ergebnisse der zuvor durch die | Bibliotheksmitarbeiter | * in durchgeführte Plagiatsprüfung besprochen | bibliothek* |

| [7] - Tina Grahl (2021). S | 5,306 | 5,306 | Ein Leitfaden zur Didaktik von | Bibliothekskursen | . Berlin : De Gruyter | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 728 | 728 | Repositorium KOBRA , Kasseler Online | Bibliothek | Repository und Archiv , ( | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 914 | 914 | unstrittig ( vgl . Deutscher | Bibliotheksverband | 2020 ) . Mit Ausbruch | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 928 | 928 | der damit einhergehenden Schließung der | Bibliotheksstandorte | wurde die Relevanz für den | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 985 | 985 | Umfrage zu Lizenzierungsentscheidungen an wissenschaftlichen | Bibliotheken | und Regionalbibliotheken in Deutschland gaben | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 1,600 | 1,600 | Fachreferent * innen an die | Bibliotheksbeauftragten | und weitere Kontakte im Fachbereich | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 2,348 | 2,348 | Segment der Zweitveröffentlichungen , die | Bibliotheken | ohne weitere Rückfrage vornehmen dürfen | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 2,805 | 2,805 | Interesse an den auf der | Bibliothekskommissionssitzung | im November 2020 präsentierten Zwischenergebnissen | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 3,639 | 3,639 | es sich nicht um ein | bibliothekarisches | Binnenthema der Literaturversorgung handelt , | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 5,438 | 5,438 | Wissenschaftler * innen gibt der | Bibliothek | wertvolle Einsichten in die Publikationskultur | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 6,229 | 6,229 | zu Berlin veröffentlicht https://edoc.hu-berlin.de/. Deutscher | Bibliotheksverband | ( 2020 ) : Bericht | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 6,238 | 6,238 | : Bericht zur Lage der | Bibliotheken | : Fakten und Zahlen 2020–2021 | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 6,395 | 6,395 | aus der Universitätsbibliothek Kassel . | Bibliotheksdienst | 54 ( 12 ) , | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 6,562 | 6,562 | Erbe und zeitgemäße Informationsinfrastrukturen : | Bibliotheken | am Anfang des 21 . | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 6,626 | 6,626 | . O-Bib . Das Offene | Bibliotheksjournal | , 5 ( 4 ) | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 6,690 | 6,690 | Universitätsbibliothek , Landesbibliothek und Murhardsche | Bibliothek | der Stadt Kassel ( 2020 | bibliothek* |

| [8] - Sarah Dellmann, Arvi | 6,795 | 6,795 | : O-Bib . Das Offene | Bibliotheksjournal | 8 ( 1 ) , | bibliothek* |

| [9] - Berfu Erdogan, Chris | 461 | 461 | – Wissenschaftliche Universalbibliotheken des Deutschen | Bibliotheksverbandes | ( dbv ) sowie die | bibliothek* |

| [9] - Berfu Erdogan, Chris | 1,001 | 1,001 | durch die beteiligten Projekte und | Bibliotheken | stets dokumentiert werden . Die | bibliothek* |

| [10] - Grischa Fraumann, Ch | 511 | 511 | Handreichungen , die im Bereich | Bibliotheks- | und Informationswissenschaften veröffentlicht wurden , | bibliothek* |

| [11] - Christian Hauschke, | 2,991 | 2,991 | . O-bib . Das offene | Bibliotheksjournal | , 8 ( 1 ) | bibliothek* |

| [12] - Jana Madlen Schütte | 43 | 43 | Regionalbibliotheken zum Strategiepapier „ Wissenschaftliche | Bibliotheken | 2025 “ haben sie sich | bibliothek* |

| [12] - Jana Madlen Schütte | 56 | 56 | der Open-Access-Transformation bekannt . Die | Bibliotheken | beginnen aktuell damit , Publikationsservices | bibliothek* |

| [12] - Jana Madlen Schütte | 477 | 477 | gelenkt werden : Auf dem | Bibliothekartag | 2019 haben Anne May und | bibliothek* |

| [12] - Jana Madlen Schütte | 490 | 490 | von der Gottfried Wilhelm Leibniz | Bibliothek | ( GWLB ) in Hannover | bibliothek* |

| [12] - Jana Madlen Schütte | 551 | 551 | diese als Anknüpfungspunkte für andere | Bibliotheken | dieses Typs an ( May | bibliothek* |

| [12] - Jana Madlen Schütte | 579 | 579 | , die Gottfried Wilhelm Leibniz | Bibliothek | in Hannover und die Herzog | bibliothek* |

| [12] - Jana Madlen Schütte | 586 | 586 | Hannover und die Herzog August | Bibliothek | in Wolfenbüttel , im Rahmen | bibliothek* |

| [12] - Jana Madlen Schütte | 655 | 655 | Regionalbibliotheken zum Strategiepapier „ Wissenschaftliche | Bibliotheken | 2025 “ , die ebenfalls | bibliothek* |

| [12] - Jana Madlen Schütte | 1,058 | 1,058 | Forschungsbibliotheken bzw . diejenigen Öffentlichen | Bibliotheken | mit regionalem Charakter hier Entwicklungspotential | bibliothek* |

| [12] - Jana Madlen Schütte | 1,113 | 1,113 | Stellenwertes des Themas für den | Bibliothekstyp | und die eigene Einrichtung ist | bibliothek* |

| [12] - Jana Madlen Schütte | 1,619 | 1,619 | Regionalbibliotheken zum Strategiepapier „ Wissenschaftliche | Bibliotheken | 2025 " ( WB2025 ) | bibliothek* |

| [12] - Jana Madlen Schütte | 1,660 | 1,660 | am Beispiel der GWLB . | Bibliothekartag | 2019 [ Präsentationsfolien ] . | bibliothek* |

| [13] - Thomas Mutschler (20 | 250 | 250 | justiert , sondern auch die | Bibliothekswelt | grundlegend verändert . An zahlreichen | bibliothek* |

| [13] - Thomas Mutschler (20 | 258 | 258 | . An zahlreichen Standorten sind | Bibliotheken | nicht nur Servicepartner für die | bibliothek* |

| [13] - Thomas Mutschler (20 | 364 | 364 | der Sektion 4 des Deutschen | Bibliotheksverbands | ( AG Regionalbibliotheken ) wurde | bibliothek* |

| [13] - Thomas Mutschler (20 | 531 | 531 | AG Regionalbibliotheken zum Strategiepapier Wissenschaftliche | Bibliotheken | 2025 , welches ebenfalls ein | bibliothek* |

| [13] - Thomas Mutschler (20 | 983 | 983 | ) . Gleichzeitig wurden die | Bibliotheken | dazu aufgefordert , beim Aufbau | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,004 | 1,004 | … ) werden die wissenschaftlichen | Bibliotheken | in Thüringen ihre Leistungen in | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,061 | 1,061 | . Mitarbeiter * innen der | Bibliothek | schufen in Kooperation mit dem | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,094 | 1,094 | sogenannten Hochschulschriftenservers . Die Digitale | Bibliothek | Thüringen ( https://www.db-thueringen.de ) war | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,163 | 1,163 | Publizieren und den Aufbau digitaler | Bibliotheken | " fördern ( § 38 | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,185 | 1,185 | Jahr 2001 hat die Digitale | Bibliothek | Thüringen mehrere Relaunches und Zertifizierungen | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,272 | 1,272 | am Reichtum der in Thüringer | Bibliotheken | , Archiven und Museen verwahrten | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,383 | 1,383 | da sie neben der Digitalen | Bibliothek | Thüringen einen zentralen Baustein innerhalb | bibliothek* |

| [13] - Thomas Mutschler (20 | 1,716 | 1,716 | sowohl in die Deutsche Digitale | Bibliothek | ( https://www.deutsche-digitale-bibliothek.de ) als auch | bibliothek* |

| [13] - Thomas Mutschler (20 | 2,091 | 2,091 | gestellt wurde und von der | Bibliothek | gemanagt wird . Auf der | bibliothek* |

| [13] - Thomas Mutschler (20 | 2,329 | 2,329 | ) in den Suchindex der | Bibliothek | . Der begonnene Ausbau der | bibliothek* |

| [13] - Thomas Mutschler (20 | 2,488 | 2,488 | Kontext des elektronischen Publizierens umfasst | bibliothekarische | Dienste und Beratungsangebote . Open | bibliothek* |

| [13] - Thomas Mutschler (20 | 2,839 | 2,839 | auch Werke sieht sich die | Bibliothek | als Servicepartner sowohl für die | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,034 | 3,034 | Landesbibliothek Jena zudem in den | Bibliotheksverbünden | zur Verfügung . Digitalisierte Quellen | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,062 | 3,062 | auch für die Organisation der | bibliothekarischen | Arbeitsprozesse mit sich – ein | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,091 | 3,091 | sowie in anderen Bereichen der | Bibliothek | machten sich mit den neuen | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,209 | 3,209 | die eigene Einrichtung . Die | Bibliothek | verifiziert nicht nur , wer | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,302 | 3,302 | beschränkt sich die Rolle der | Bibliotheken | im digitalen Zeitalter längst nicht | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,318 | 3,318 | Informations- und Literaturversorgung , sondern | Bibliotheken | sind heutzutage mehr denn je | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,411 | 3,411 | Auch auf die Organisation der | bibliothekarischen | Arbeitsprozesse hat die Open Access-Transformation | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,551 | 3,551 | Geschäftsmodelle stehen , ist für | Bibliotheken | mit ausschließlich regionalem Versorgungsauftrag nicht | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,585 | 3,585 | sofern dies aus Lizenzverträgen der | Bibliotheken | abgeleitet wird . Hinzu kommt | bibliothek* |

| [13] - Thomas Mutschler (20 | 3,780 | 3,780 | ihre Publikationsinfrastruktur , sondern auch | bibliothekarisches | und wissenschaftliches Knowhow zur Verfügung | bibliothek* |